【導讀】智能車環(huán)境感知系統(tǒng)的一個重要任務就是實時地提供車輛在行使過程中的位置信息。機器視覺因其有信號探測范圍寬、獲取信息完整、符合人類認知習慣、維護成本低、不產生環(huán)境污染等多優(yōu)點,已在智能車環(huán)境感知系統(tǒng)中廣泛采用。

機器視覺車輛環(huán)境感知系統(tǒng)中的主要任務是完成道路及目標的識別和跟蹤,為智能車行使提供必須的本車位置信息和周圍環(huán)境距離信息。

對于現(xiàn)實情況下的道路,一般可以將其分為兩大類,即:結構化道路和非結構化道路。結構化道路上有明顯的道路標記,且這些標記具有較強的幾何特征,道路路面主要是由這些標記界分確定的,如高速公路上道路中間黃色的連續(xù)標志線或白色的間斷標志線以及兩旁白色的連續(xù)標志線;非結構化道路上沒有明顯的道路標記,在二維圖像中道路路面與非路面主要依靠紋理與色彩而區(qū)分的,如沒有標記的水泥路、野外土路或石板路等。

彎道圖像包含豐富的道路信息和環(huán)境信息,解釋了道路周圍場景。彎道檢測是從道路圖像中檢測出彎曲車道線的邊界,這也是對彎道理解的基礎。建立彎道模型;提取車道線像素點;擬合車道線模型屬于目前較常采用的認知方法,并在特定的結構化道路體現(xiàn)出較好的檢測效果。文獻[6]介紹了彎道檢測在車道偏離預警、彎道限速以及彎道防碰撞預警等領域的應用情況,并提出了彎道檢測應該建立三維車道線模型,提高適用性。

均采用的Hough變換求出車道線直線方程,從而確定對應直線段上的最低點和最高點,然后根據(jù)相應準則判斷曲線道路的彎曲方向,最后分段擬合車道線的直線段和曲線段實現(xiàn)車道線的二維重建。

彎道檢測不僅需要識別出道路邊界線,還需要判斷道路彎曲方向,確定轉彎的曲率半徑。常用的車道檢測方法可分為2大類:基于道路特征和基于道路模型的方法。目前國外主要常用基于道路模型的方法,即將彎道檢測轉化為各種曲線模型中數(shù)學參數(shù)的求解問題。省略彎道曲線模型建立和數(shù)學參數(shù)的復雜求解過程,本文采用立體視覺感知環(huán)境的三維信息,利用它的視差原理對所獲取室內道路周邊環(huán)境圖像中角點特征的位置恢復其三維信息來判斷車體的彎道轉向和偏航角度。建立了視覺信息直接控制車體驅動偏離角與偏離距離視覺伺服控制系統(tǒng),初步采用了BP控制策略,利用Simulink仿真環(huán)境實現(xiàn)了針對未知彎道曲率的智能車轉彎控制運動。

1 室內道路環(huán)境信息的視覺感知

1.1 立體視覺系統(tǒng)模型

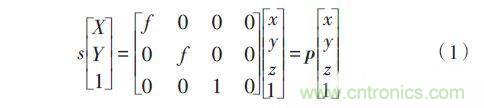

采用針孔成像模型將圖像中任何點的投影位置與實際點的物理位置建立連線關系,攝像機光心O與空間P點間的連線OP與圖像平面的交點即為圖像投影的位置(u,v)。用齊次坐標和矩陣表示上述透視投影關系為:

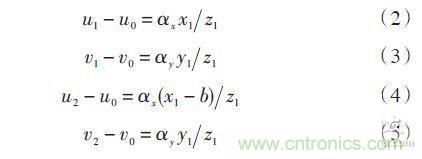

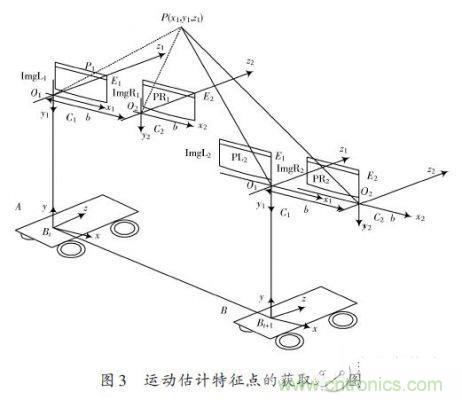

本文采用的雙目平行相機的模型如圖1所示,C1與C2攝像機的焦距相等,各內部參數(shù)也相等,而且兩個相機的光軸互相平行,x軸互相重合,y軸互相平行,因此,將第一個攝像機沿x軸平移一段距離b后與第二個攝像機完全重合。假設C1坐標系為O1 x1 y1 z1,C2坐標系為O2 x2 y2 z2,則在上述攝像機配置下,若任何空間點P的坐標在C1坐標系下為(x1),y1,z1,在C2坐標系下為(x1)-b,y1,z1。由中心攝影的比例關系可得:

其中(u1,v1)、(u2,v2)分別為P1與P2的圖像坐標。由P1與P2的圖像坐標(u2,v2)、(u2,v2)可求出空間點P的三維坐標(x1,y1,z1)。

1.2 室內環(huán)境特征向量的提取與匹配

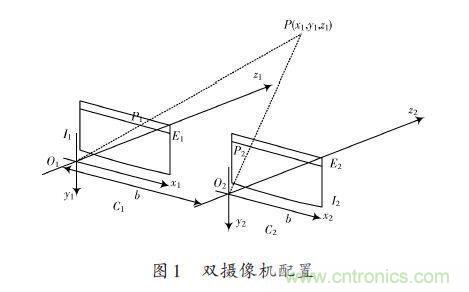

由于噪聲、光照變化、遮擋和透視畸變等因素的影響,空間同一點投影到兩個攝像機的圖像平面上形成的對應點的特性可能不同,對在一幅圖像中的一個特征點或者一小塊子圖像,在另一幅圖像中可能存在好幾個相似的候選匹配。因此需要另外的信息或者約束作為輔助判據(jù),以便能得到惟一準確的匹配。最近鄰法是一種有效的為每個特征點尋找匹配點的方法。最近鄰點被定義為與特征點的不變描述子向量之間的歐氏距離最短的點。

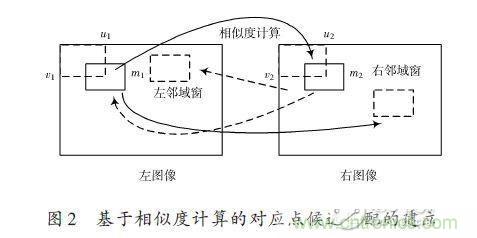

假定參考圖像P的SIFT特征點集合為:FP ={FP (1),F(xiàn)P (2),-,F(xiàn)P (m)},m為圖像P的特征點的個數(shù);待匹配圖像Q的特征點的個數(shù)為N,SIFT特征點集合為FQ ={FQ (1),F(xiàn)Q (2),-,F(xiàn)Q (m)}。當在建立參考圖像中的特征點和待匹配圖像的特征篩選對應匹配關系時,應按照圖2所示的算法進行對稱性測試,只有當兩個匹配集中的對應點完全一致時,才視為有效匹配。

SIFT特征向量生成后,利用特征點向量的歐式距離來作為兩幅圖像中特征點的相似性判定度量。最近鄰法是一種有效的為每個特征點尋找匹配點的方法。

最近鄰點被定義為與特征點的不變描述子向量之間的歐氏距離最短的點。對特征點集合FP中的每個點,逐一計算其與特征點集合FQ中每個點的距離,得到特征點之間的距離集合D。將距離集合D中的元素進行排序,得到最近鄰距離dmin和次近鄰距離dn–nim。SIFT算法通過判斷最近鄰和次近鄰距離的比值:

來區(qū)分正確匹配對和錯誤匹配對。

對于正確的匹配對,其最近鄰距離dmin要遠遠小于次近鄰距離dn-nim,即DistanceRatio-1;而錯誤的匹配對,由于特征空間的維數(shù)很高,其最近鄰距離dmin與次近鄰距離dn-nim差距不大,即DistanceRatio≈1。所以可取一個距離比閾值Threh∈(0,1)來區(qū)分正確匹配對和錯誤匹配對。

1.3 運動估計

進行特征點立體匹配和跟蹤匹配如圖2所示,對當前時刻t獲得圖像對(ImgL1和ImgL2)進行SIFT特征匹配之后獲得道路環(huán)境匹配特征點Ni個,再對相鄰時刻t+1獲得的Ni+1個特征點計算歐式距離,尋找t與t+1時刻獲取圖像中相同的特征點,得到一系列匹配點在車體運動前后的三維坐標。

本文實驗環(huán)境是在室內,在假定室內環(huán)境為理想的水平面的基礎上,同一特征點三維坐標中y坐標保持基本不變,即車體運動參數(shù)僅在x-z坐標平面內發(fā)生變化。

圖3中點P(x1,y1,z1)為所提取環(huán)境特征點,在t時刻立體匹配后得到其在攝像頭坐標系下的三維坐標,由于攝像頭固定安裝在小車上,因此通過坐標系的旋轉與平移變換可將點P的三維坐標轉換到小車坐標系ΣBt下表示。同理,t+1時刻所獲取的圖像中相同點P的(u,v)二維坐標發(fā)生變化,經坐標轉換后可得到小車坐標系ΣBt+1下表示。

小車t時刻位于位置A時,特征點P在坐標系ΣBt為參考位置的三維坐標是[x1],y1,z1T,當經過t+1時刻后移動到空間位置B時,同一特征點P在以B為參考位置的三維坐標為[x]t+1,yt+1,zt+1T,所以得到:

當這些位置滿足3個及以上相同的匹配特征點時,小車所在坐標系間的平移與旋轉向量就可以通過以上方程獲得。

2 車體的轉彎控制

2.1 車體定位參數(shù)計算

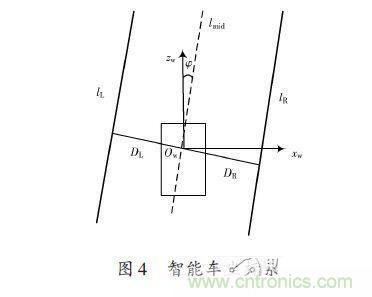

環(huán)境特征點投影到車體坐標系下表示后,即為所有的環(huán)境坐標均統(tǒng)一在世界坐標系下的表示。如圖4所示,其中小車前進方向為zw軸,xw水平垂直于zw,方向向右,其交點為原點Ow。直線為lmid為道路中間線,lmid與zw的夾角為φ,即為車輛的偏航角。點Ow到左車道線lL的距離為DL,到右車道線lR的距離為DR,可行駛區(qū)域的道路寬度為w = DL+DR。

2.2 彎道控制策略

2.2.1 控制策略

機器人的底層運動控制是非常重要的一個環(huán)節(jié),機器人運動控制的好壞直接決定了能否有效執(zhí)行決策意圖,準確無誤地沿著預定軌跡行進,完成導航任務。傳統(tǒng)的定位控制中,PI、PID是廣泛采用的控制方法,這些方法比較成熟,但卻具有一定的局限性。對被控系統(tǒng)的參數(shù)變化比較敏感,難以克服系統(tǒng)中非線性因素的影響。本文采用BP神經網絡控制器在行使過程中經學習對網絡進行訓練,以適應當前的環(huán)境路況來調整車的左右輪速控制量。智能車左右輪速的大小,和車體偏離道路中間線lmid的距離d和車運動時方向偏離中間線的角度φ有關。小車控制輸入為d,φ,輸出為VL,VR。

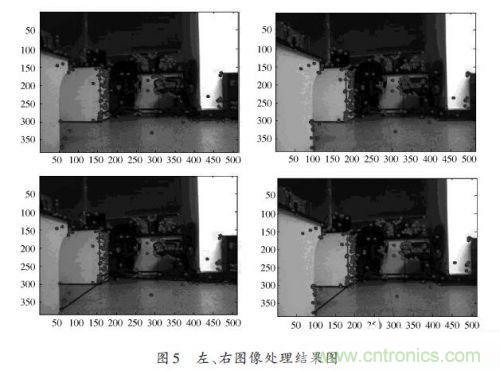

基于雙目立體視覺獲取得到的三維信息,即為經左右圖像SIFT特征點匹配,在攝像頭坐標系中獲取前景環(huán)境中各關鍵點的坐標信息。選取關鍵點中與機器人基坐標系原點高度靠近的點,并且該點的個數(shù)需大于3,之后,采用最小二乘法擬合可得行駛區(qū)域的邊界直線,即確定了車體定位參數(shù)中左、右車道線lL、lR。直線與圖像右邊界存在交點,即可判斷出彎道轉向。同時,擬合確定的左車道線與圖像下邊緣的交點Pl0為第一個控制點;以圖像右邊界與擬合直線的交點處為第二個控制點Pln。圖5表示為前景環(huán)境中對特征點的匹配結果圖和判斷可行駛區(qū)域。

對序列圖像進行實時處理時,由于攝像機采集系統(tǒng)速度為30幀/s,車速在不超過33cm/s的情況下,采集一幀圖像智能車向前行駛約小于1cm,連續(xù)采集的兩幀圖像中所判斷的車道左右車道線和彎道方向偏差不會太大。

2.2.2 控制仿真實驗

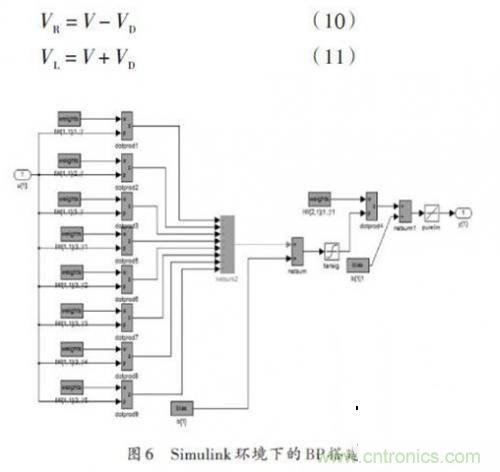

實驗采用BP神經網絡作為控制對偏離角φ進行仿真實驗。在Simulink環(huán)境下搭建的系統(tǒng)模型中BP神經網絡的搭建如圖6所示。U為經由視覺信息得到的偏航角φ作為系統(tǒng)輸入量,輸出Y為小車質心速度V。小車左、右輪速可在判斷彎道轉向的前提下,由兩輪速差VD經計算得出。若如圖5所示,彎道轉向向右:

利用Simulink庫中Signal Builder產生變化的Signal仿真實際環(huán)境中視覺系統(tǒng)得到的當前車體的偏移量。

小車經左右輪差速轉彎運動中質心位置實際偏轉角度作為網絡的輸入,經訓練學習反饋回系統(tǒng)的控制輸入端。圖7為控制仿真結果圖,由圖示可知該方法基本完成了對信號的控制跟蹤,由此說明了利用雙目立體視覺所獲得的信息,并采用BP網絡自學習對道路的變化可適用于不同彎道的道路,避免了傳統(tǒng)PID控制方法因彎道曲率變化使得小車轉彎控制失敗。

3 結論

借助機器視覺系統(tǒng)判斷小車可行駛區(qū)域,同時還可清晰地判斷出彎曲線路的走向,避免了彎道方向的復雜判別方法,且該方法普遍適用于不同的道路環(huán)境,特別是非結構化的道路環(huán)境,也增強了算法的實用性和魯棒性。但目前對雙目攝像機進行精確匹配和標定仍然是個技術難題;神經網絡訓練方法在選取訓練樣本數(shù)據(jù)和精確定位車輛位置方面也比較困難,這將是進一步研究的主要關鍵問題。來源:電子發(fā)燒友。

【推薦閱讀】